Mit dem Ende der Ampel-Koalition in Deutschland verschärft sich die Unsicherheit für die angeschlagene deutsche Wirtschaft – und das zu einem Zeitpunkt, zu dem nach der US-Wahl ohnedies neue Herausforderungen auf Europas größte Volkswirtschaft zukommen. Expert:innen sehen in dem kommenden Regierungswechsel in Deutschland aber auch eine Chance für eine Neuausrichtung und nötige Reformen.

Riskanter Schritt des Bundeskanzlers

„Die Entscheidung des Bundeskanzlers zur Beendigung dieser Regierung zu diesem Zeitpunkt ist riskant“, sagte der Präsident des Deutschen Instituts für Wirtschaftsforschung (DIW) Marcel Fratzscher der Nachrichtenagentur Reuters. Sie dürfte jedoch das geringere Übel im Vergleich zu einer Fortsetzung der politischen und wirtschaftlichen Paralyse sein, so Fratscher.

„Die Ampel-Koalition war kaum noch handlungsfähig und die politische Unsicherheit in Deutschland ohnehin sehr hoch. Mit Neuwahlen besteht die Chance auf einen Befreiungsschlag“, sagte auch der Präsident des Leibniz-Zentrums für Europäische Wirtschaftsforschung (ZEW), Achim Wambach, der Deutschen Presse-Agentur.

Deutsche Wirtschaft in der Krise

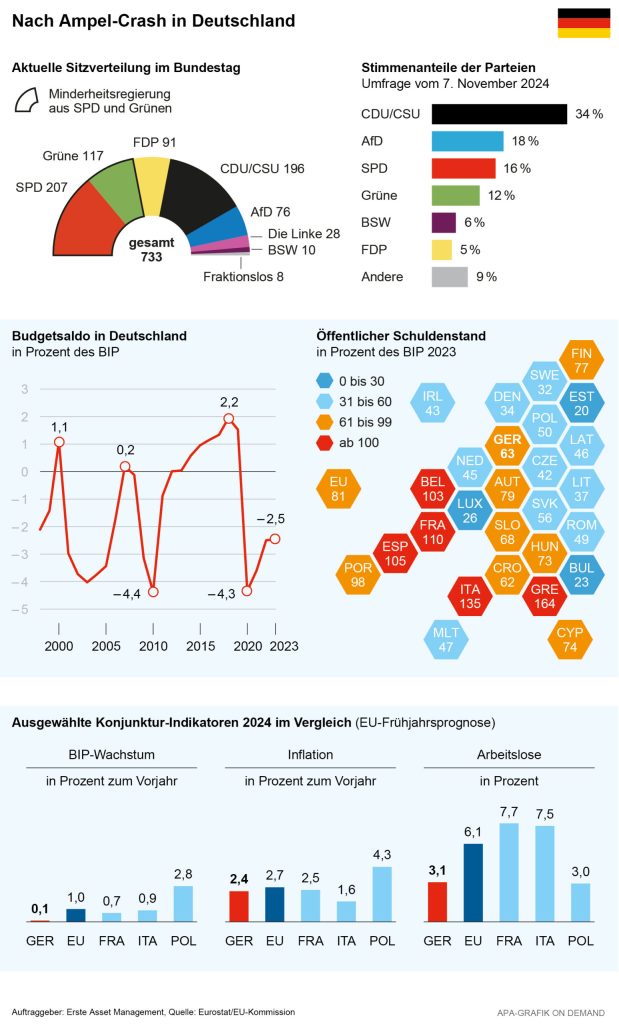

Die kriselnde deutsche Wirtschaft ist im dritten Quartal wegen höherer Konsumausgaben überraschend gewachsen. Das Bruttoinlandsprodukt (BIP) legte laut einer ersten Schätzung des Statistischen Bundesamts von Juli bis September um 0,2% im Vergleich zum Vorquartal zu. Auch der Ifo-Geschäftsklimaindex, der als wichtigster Frühindikator für die deutsche Konjunkturentwicklung gilt, stieg im Oktober nach zuvor vier Rückgängen in Folge erstmals wieder. Zuletzt kamen aus der angeschlagenen deutschen Konjunktur aber wieder Zeichen der Schwäche.

Trotz eines gut laufenden US-Geschäfts lagen die Ausfuhren von deutschen Waren im September mit 128,2 Mrd. Euro um 1,7% unter dem Vormonat. Die wachsende Konkurrenz aus Ländern wie China und die im internationalen Vergleich hohen Energiepreise machen der Exportnation Deutschland schon seit einiger Zeit zu schaffen. Die Unternehmen drosselten zudem ihre Produktion wegen der schwächelnden Autobranche überraschend stark: Industrie, Bau und Energieversorger stellten zusammen 2,5% weniger her als im August.

Die Unsicherheit wegen der Neuwahl könnte auf der Verbraucherstimmung lasten. „Wir gehen davon aus, dass das Ampel-Aus belastend auf die Konsumstimmung wirken wird“, sagte Rolf Bürkl vom Nürnberg Institut für Marktentscheidungen (NIM) zuletzt der Nachrichtenagentur Reuters.

Trump-Wahl schürt Sorgen um Exportwirtschaft

Sorgen macht deutschen Ökonomen auch die Wahl Trumps. Sie fürchten, dass Trump mit seinen Zollplänen einen Handelskrieg zwischen der EU und den USA anzetteln könnte. Der designierte US-Präsident hat neue Zölle von 10 bis 20% auf Importe aus Europa angekündigt. Für Waren aus China sprach Trump sogar von 60%, Europa wäre also im Vorteil. Dennoch dürften die Strafzölle Deutschland schwer treffen. Die USA sind der wichtigste Absatzmarkt für die deutsche Exportwirtschaft, die geplanten Zölle würden deutsche Produkte aber in den Staaten deutlich teurer und damit unattraktiver machen.

Die geplanten Zollerhöhungen könnten das BIP im nächsten Jahr um etwa 0,3% und in den nachfolgenden Jahren bis zu 1,2% reduzieren, sagte der Direktor des Instituts der deutschen Wirtschaft (IW), Michael Hüther den Zeitungen der Funke Mediengruppe. Auch bei Gegenmaßnahmen durch die EU im Handelsstreit würden die negativen BIP-Effekte bis 2028 zunehmen.

Die geplanten Zollerhöhungen des künftigen US-Präsidenten Donald Trump würden die deutsche Exportwirtschaft schwer treffen. © unsplash

„Die USA ist seit neun Jahren Deutschlands wichtigster Handelspartner. Diese Lücke mit inländischem und europäischem Konsum des Binnenmarkts zu füllen, wird fast unmöglich“, so Hüther. Experten erwarten, dass die Zollerhöhungen vor allem die Automobilindustrie, den Maschinenbau, aber auch die Pharma- und Chemiebranche stark treffen würden, da sie überdurchschnittliche Exportquoten in die USA aufwiesen.

Schlechte Aussichten für Autobranche

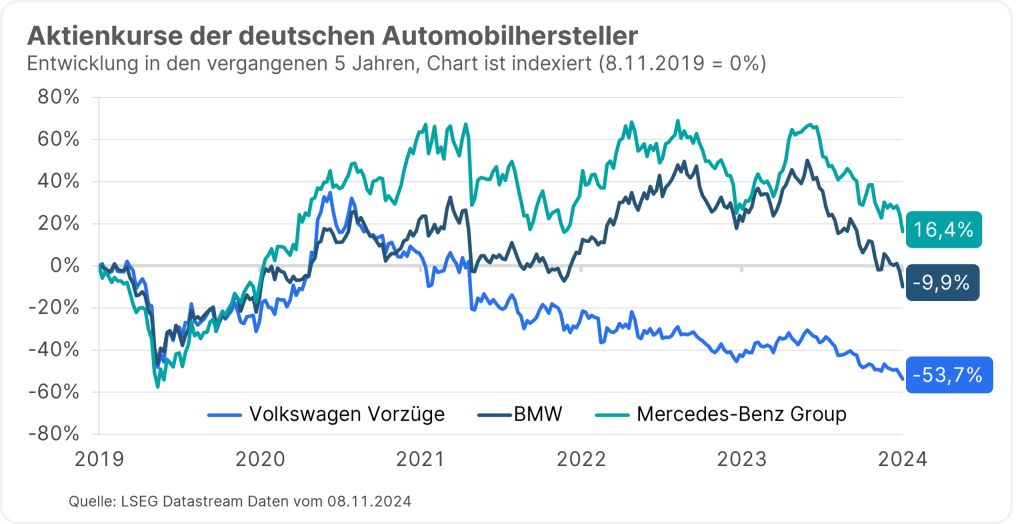

Damit könnte die ohnedies schon angeschlagene Automobilbranche noch stärker ins Kriseln kommen. Die Stimmung in der deutschen Autoindustrie hat sich schon vor dem Wahlsieg von Donald Trump deutlich eingetrübt. Das vom ifo-Institut in einer Unternehmensumfrage ermittelte Barometer für das Geschäftsklima fiel im Oktober von minus 23,4 Zählern im Vormonat auf minus 27,7 Punkte.

Hinweis: Die Entwicklung in der Vergangenheit ist kein zuverlässiger Indikator für künftige Wertentwicklungen.

Die Aktienkurse der großen deutschen Automobilhersteller bekamen die Schwäche in der Branche in den vergangenen Monaten deutlich zu spüren. Quelle: LSEG Datastream

Auch die Exporterwartungen der deutschen Autobranche haben sich im Oktober nochmals verschlechtert. Der entsprechende Indikator fiel auf minus 32,8 Punkte. Nur während der ersten Coronawelle im Frühjahr 2020 lag der Wert darunter. „Der deutschen Autoindustrie scheint der intensiver werdende Wettbewerb vor allem aus dem außereuropäischen Ausland zunehmend zuzusetzen“, erklärte Ifo-Branchenexpertin Anita Wölfl den Abwärtstrend.

Chancen für deutsche Konzerne mit Produktionsstandorten in den USA

Für deutsche Konzerne, die in den USA produzierten, könnten sich unter Trump aber Chancen ergeben. „Trump wird wahrscheinlich nicht nur Zölle erhöhen, sondern auch die Unternehmenssteuern senken. Für manche deutsche Firmen vor Ort ist die Wahl von Trump „good news“, glaubt der ZEW-Präsident Wambach. Schon im vergangenen Jahr haben Unternehmen, etwa aus der Pharma- und Chemieindustrie, verstärkt in den USA investiert, angelockt von niedrigen Energiepreisen und einem milliardenschweren Subventionsprogramm. Und deutsche Autobauer haben seit Jahren große Werke in den USA.

Die Wahl von Trump dürfte den Standort USA noch attraktiver machen, meint Wambach. „Unternehmen werden darauf reagieren und noch stärker vor Ort produzieren.“ Der Standort Deutschland laufe hingegen Gefahr, Produktion und Forschung noch stärker an die USA zu verlieren. Deutschland brauche daher umso mehr Reformen, zum Beispiel Bürokratieabbau. Auch die EU müsse „selbst auferlegte Fesseln ablegen“, mahnt Wambach mit Blick auf komplexe Regelwerke wie das EU-Lieferkettengesetz und Datenschutzgrundverordnung.

Experten fordern möglichst frühe Neuwahl und Neustart mit Reformen

Top-Manager erhoffen von der neuen Regierung ein schnelleres Reformtempo, unter anderem bei Bürokratieabbau und anderen Maßnahmen zur Standort-Stärkung. „Jeder Monat mit fehlenden Reformen wird später nichts anderes als ein fehlendes Wachstumsjahr sein“, schrieb etwa der Deutsche-Bank-Chef Christian Sewing auf der Plattform LinkedIn. „Wir sind überzeugt, dass Deutschland ein großes Potenzial hat“, so Sewing, „aber wir müssen jetzt handeln, damit wir Anschluss halten und unsere Wirtschaft dieses Potenzial entfalten kann.“ Der für Deutschland wichtige Chemiesektor forderte zuletzt ebenfalls über seinen Branchenverband weitreichende Reformen und Bürokratieabbau zur Stärkung des Standorts ein.

Die Unsicherheit in der ohnehin schon schwächelnden deutschen Wirtschaft nimmt nach dem Ende der Regierungskoalition weiter zu. Zusätzlich dürfte auch die bevorstehende zweite Periode Donald Trumps als US-Präsident vor allem den Exportsektor belasten.

Wirtschaftsvertreter sehen im Ende der Ampel-Koalition und dem Ergebnis der US-Wahl aber auch Chancen für die viertgrößte Volkswirtschaft der Erde. Neuwahlen bringen demnach auch die Möglichkeit für dringen benötigte Reformen. Um wettbewerbsfähig zu bleiben, fordert die Wirtschaft eine rasche Neuausrichtung und einen Abbau von Bürokratie.

Bis zur derzeit für März avisierten Neuwahl droht Deutschland aber vorerst ein Stillstand. So kann Bundeskanzler Olaf Scholz etwa sein im Oktober angekündigtes milliardenschweres Maßnahmenpaket zur Unterstützung der Automobil- und Chemiebranche mangels einer Mehrheit wohl nicht mehr im geplanten Umfang umsetzen. Unternehmer und Ökonomen pochen daher auf möglichst baldige Neuwahlen, um den drohenden Stillstand bis zum erhofften Neustart so kurz wie möglich zu halten.

Hinweis: Prognosen sind kein zuverlässiger Indikator für künftige Wertentwicklungen.

WICHTIGE RECHTLICHE HINWEISE

Hierbei handelt es sich um eine Werbemitteilung. Sofern nicht anders angegeben, Datenquelle Erste Asset Management GmbH. Die Kommunikationssprache der Vertriebsstellen ist Deutsch und jene der Verwaltungsgesellschaft zusätzlich auch Englisch.

Der Prospekt für OGAW-Fonds (sowie dessen allfällige Änderungen) wird entsprechend den Bestimmungen des InvFG 2011 idgF erstellt und veröffentlicht. Für die von der Erste Asset Management GmbH verwalteten Alternative Investment Fonds (AIF) werden entsprechend den Bestimmungen des AIFMG iVm InvFG 2011 „Informationen für Anleger gemäß § 21 AIFMG“ erstellt.

Der Prospekt, die „Informationen für Anleger gemäß § 21 AIFMG“ sowie das Basisinformationsblatt sind in der jeweils aktuell gültigen Fassung auf der Homepage www.erste-am.com jeweils in der Rubrik Pflichtveröffentlichungen abrufbar und stehen dem/der interessierten Anleger:in kostenlos am Sitz der jeweiligen Verwaltungsgesellschaft sowie am Sitz der jeweiligen Depotbank zur Verfügung. Das genaue Datum der jeweils letzten Veröffentlichung des Prospekts, die Sprachen, in denen der Prospekt bzw. die „Informationen für Anleger gemäß § 21 AIFMG“ und das Basisinformationsblatt erhältlich sind, sowie allfällige weitere Abholstellen der Dokumente, sind auf der Homepage www.erste-am.com ersichtlich. Eine Zusammenfassung der Anlegerrechte ist in deutscher und englischer Sprache auf der Homepage www.erste-am.com/investor-rights abrufbar sowie bei der Verwaltungsgesellschaft erhältlich.

Die Verwaltungsgesellschaft kann beschließen, die Vorkehrungen, die sie für den Vertrieb von Anteilscheinen im Ausland getroffen hat, unter Berücksichtigung der regulatorischen Vorgaben wieder aufzuheben.

Hinweis: Sie sind im Begriff, ein Produkt zu erwerben, das schwer zu verstehen sein kann. Bevor Sie eine Anlageentscheidung treffen, empfehlen wir Ihnen, die erwähnten Fondsdokumente zu lesen. Diese Unterlagen erhalten Sie zusätzlich zu den oben angeführten Stellen kostenlos am jeweiligen Sitz der vermittelnden Sparkasse und der Erste Bank der oesterreichischen Sparkassen AG. Sie können die Unterlagen auch elektronisch abrufen unter www.erste-am.com.

Unsere Analysen und Schlussfolgerungen sind genereller Natur und berücksichtigen nicht die individuellen Merkmale unserer Anleger:innen hinsichtlich des Ertrags, der steuerlicher Situation, Erfahrungen und Kenntnisse, des Anlageziels, der finanziellen Verhältnisse, der Verlustfähigkeit oder Risikotoleranz. Die Wertentwicklung der Vergangenheit lässt keine verlässlichen Rückschlüsse auf die zukünftige Entwicklung eines Fonds zu.

Bitte beachten Sie: Eine Veranlagung in Wertpapieren birgt neben den geschilderten Chancen auch Risiken. Der Wert von Anteilen und deren Ertrag können sowohl steigen als auch fallen. Auch Wechselkursänderungen können den Wert einer Anlage sowohl positiv als auch negativ beeinflussen. Es besteht daher die Möglichkeit, dass Sie bei der Rückgabe Ihrer Anteile weniger als den ursprünglich angelegten Betrag zurückerhalten. Personen, die am Erwerb von Investmentfondsanteilen interessiert sind, sollten vor einer etwaigen Investition den/die aktuelle(n) Prospekt(e) bzw. die „Informationen für Anleger gemäß § 21 AIFMG“, insbesondere die darin enthaltenen Risikohinweise, lesen. Ist die Fondswährung eine andere Währung als die Heimatwährung des/der Anleger:in, so können Änderungen des entsprechenden Wechselkurses den Wert der Anlage sowie die Höhe der im Fonds anfallenden Kosten – umgerechnet in die Heimatwährung – positiv oder negativ beeinflussen.

Wir dürfen dieses Finanzprodukt weder direkt noch indirekt natürlichen bzw. juristischen Personen anbieten, verkaufen, weiterverkaufen oder liefern, die ihren Wohnsitz bzw. Unternehmenssitz in einem Land haben, in dem dies gesetzlich verboten ist. Wir dürfen in diesem Fall auch keine Produktinformationen anbieten.

Zu den Beschränkungen des Vertriebs des Fonds an amerikanische oder russische Staatsbürger entnehmen Sie die entsprechenden Hinweise dem Prospekt bzw. den „Informationen für Anleger gemäß § 21 AIFMG“.

In dieser Mitteilung wird ausdrücklich keine Anlageempfehlung erteilt, sondern lediglich die aktuelle Marktmeinung wiedergegeben. Diese Mitteilung ersetzt somit keine Anlageberatung.

Die Unterlage stellt keine Vertriebsaktivität der Verwaltungsgesellschaft dar und darf somit nicht als Angebot zum Erwerb oder Verkauf von Finanz- oder Anlageinstrumenten verstanden werden.

Die Erste Asset Management GmbH ist mit der Erste Bank und den österreichischen Sparkassen verbunden.

Beachten Sie auch die „Informationen über uns und unsere Wertpapierdienstleistungen“ Ihres Bankinstituts.